多位專家表示,由人工智能(Artificial Intelligence, AI)驅動的尖端武器正在成為全球安全隱患,尤其是當其掌握在中共手中。

專家們認為,中共急於在軍事上超越美國,因此不太可能注意與致命的人工智能技術相關的保障措施,而人工智能技術本身正變得越來越危險。他們警告說,這種技術的性質很容易助長中共政權以及整個人類的一些最壞的心理傾向。

智庫安全政策中心(Center for Security Policy)高級研究員、中國戰略評估專家、《大紀元時報》撰稿人Bradley Thayer說,「影響相當大,可能相當於核革命。」

殺手機械人

人工智能開發者、人工智能營銷公司Ink的聯合創始人Alexander De Ridder表示,目前,人工智能驅動的自主武器的開發進展迅速,非常不幸。

他對《大紀元時報》說,「它們正在迅速變得更高效、更有效」,不過,「它們還沒有達到可以取代人類的地步。」

自主無人機、坦克、艦船和潛艇已經成為現實,此外,還有一些更奇特的模式,比如中國開發的已經裝備機槍的四足機器狗。

甚至連科幻恐怖片中的人工智能仿人機械人也在生產中。當然,它們在現實世界中仍然相當笨拙,但Ridder認為,它們不會笨拙太久。

他說,「這種機械人的能力正在迅速提高。」

Ridder認為,一旦這些機械人的實用性和可靠性達到市場要求,中國很可能會憑藉其製造實力開始大規模生產,「仿人機械人將充斥市場,然後就看編程人員如何使用它們了。」

這也意味著軍事用途。他說,「這是不可避免的。」

人工智能專家、GIT研究所(GIT Research Institute)創始人、FileMaker公司前首席技術官James Qiu說,這種人工智能機器在處理圖像以辨別物體方面非常有效,譬如說,它們可以通過光學感應器探測到人類,這使得人工智能機械人非常善於瞄準目標。

Qiu表示,「這是一個非常有效的殺人機器。」

人工智能將軍

一家財富500強跨國公司的人工智能專家兼數據研究負責人Jason Ma表示,在更廣泛的層面上,多個國家正在開發能夠為戰場決策提供訊息和協調的人工智能系統——電子將軍。他不想提及該公司的名字,以免給人留下他在代表該公司發言的印象。

在中國共產黨的軍隊——中國人民解放軍(PLA)最近進行的一場戰鬥演習中,人工智能直接參與指揮。

Jason Ma指出,美國軍方也有這方面的項目,「這是一個非常活躍的研發課題。」

他解釋說,需求是顯而易見的。從歷史背景和過去的情報到近乎實時的衛星數據,再到戰場上每台攝錄機、麥克風和任何感應器的毫秒級輸入,戰場決策都要參考大量數據。

他說,人類「很難」處理如此不同的大量數據流。

他說,「戰爭越複雜,做出正確決策就變得越重要,就需要在幾秒甚至幾分之一秒內快速整合、總結所有這些訊息。」

人工智能破壞穩定

專家們一致認為,人工智能武器已經在重新定義戰爭,但其後果卻更為廣泛。Thayer說,這項技術正在使世界變得越來越不穩定。

從最基本的層面上講,人工智能驅動的武器瞄準可能會使擊落洲際彈道導彈、探測和摧毀潛艇以及擊落遠程轟炸機變得更加容易。

Thayer認為,這可能會削弱美國的核三合一能力,讓對手肆無忌憚地「升級到核級別以上」。

他說,「人工智能將影響到核三合一中的每一個組成部份,而我們在冷戰期間開發並理解這些組成部份對於穩定的核威懾關係是絕對必要的。」

他說,「冷戰期間人們普遍認為,核大國之間的常規戰爭是不可行的,但人工智能正在顛覆這一認識,因為人工智能在兩個核國家之間引入了常規衝突的可能性。」

他預測說,如果人們繼續不加限制地開發人工智能驅動的武器系統,這種不穩定性只會惡化。

他說,儘管人工智能正在極大地影響戰場,但還不是決定性的。

他說,如果人工智能達到了「不使用核武器就能打核戰爭的效果」,那世界就會陷入火藥桶。

他說,「這是很有可能的,那將是一個極其危險的局面,也是一個令人難以置信的破壞穩定的局面,因為它迫使可能受到攻擊的一方先發制人,不是忍受攻擊,而是主動侵略。」

他說,在戰爭術語中,這一概念被稱為「損害限制」,因為「你不想讓別人先動手,因為你會受到重創,所以你要先動手;這將極大地破壞國際政治的穩定。」

令人擔憂的不僅僅包括殺手機械人或無人機,還有各種非常規的人工智能武器,例如,可以開發一種人工智能來發現電網或供水系統等關鍵基礎設施的漏洞。

控制此類技術擴散顯得尤為艱巨。人工智能只是一個軟件。即使是最大的模型,也可以放在普通硬碟上,並在小型服務器群上運行。簡單但殺傷力越來越大的人工智能武器,如殺手級無人機,可以在不引起警覺得情況下分批進行運輸。

Thayer說,「縱向和橫向擴散的動力都是巨大的,而且很容易做到。」

Ridder指出,中國希望在世界舞台上被視為負責任的國家。

但其他專家也指出,這並沒有阻止中國共產黨向其它在聲譽上不那麼受限制的政權和組織提供武器或幫助其實施武器計劃。

如果中共向恐怖組織提供人工智能武器,從而使美軍陷入無休止的不對稱衝突,那也不足為奇。中共甚至可以保持距離,只提供零部件,讓代理人組裝無人機,就像中國供應商向墨西哥販毒集團提供芬太尼前體,讓他們製造、運輸和銷售毒品一樣。

例如,中共長期以來一直在援助伊朗的武器項目。反過來,伊朗也向該地區的恐怖組織提供武器。

Thayer先生說,伊朗幾乎沒有因此而受到打擊。

受人類控制

至少在美國及其盟國中,人們普遍認為,防止人工智能武器造成不可預見的破壞的最關鍵保障是讓人類控制重要決策,尤其是涉及致命武力的使用的決策。

Ridder說,「在任何情況下,都不能允許任何機器自主獨立地奪走人的生命。」

這一原則通常被概括為「受人類控制」(Human in the Loop)。

Ridder說,「人是有良知的,能在清晨醒來時感到悔恨,並為自己的所作所為承擔後果,能吸取教訓,不再重複暴行。」

然而,一些專家指出,這一人道原則已經被人工智能能力所擁有的戰鬥性質所侵蝕。

例如,在烏克蘭戰爭中,烏克蘭軍方不得不為其無人機配備一定程度的自主能力,以引導它們飛向目標,因為它們與人類操作員的通訊受到了俄羅斯軍方的干擾。

Jason Ma說,由於無人機機載電腦的功率有限,這種無人機目前只能運行較簡單的人工智能,但隨著人工智能模型和電腦的速度越來越快、效率越來越高,這種情況可能很快就會改變。

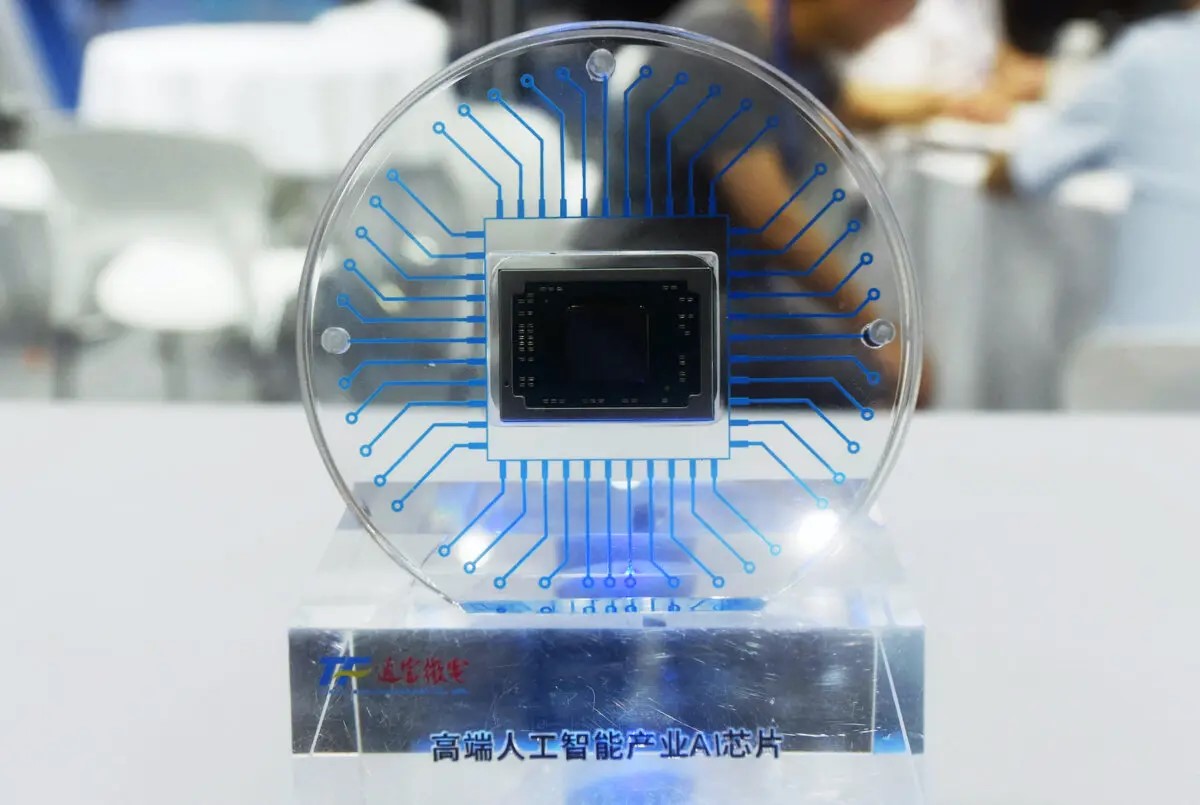

Jason Ma說,蘋果公司已經在研發一種可以在手機上運行的人工智能,「未來極有可能將其裝入一個小型晶片中」。

此外,在一次同時部署數百架甚至數千架無人機的重大衝突中,它們可以共享計算能力,執行更複雜的自主任務。

他說,「一切皆有可能,這已經超出了科幻小說的世界,而是是否有一群人願意投入時間去研究這個實實在在的技術。」

前海軍情報官員、中國問題專家(James Fanell)認為,出於必要而取消人類控制,這並不是一個新概念。

他舉了美國導彈巡洋艦和驅逐艦上部署的宙斯盾作戰系統(the Aegis Combat System)的例子。它能自動探測和跟蹤空中目標,並發射導彈將其擊落。 Fanell說,通常導彈發射由人類操作員控制,但也有辦法將其切換到自動模式,比如當目標太多,人類操作員無法追蹤時,系統會自行識別並摧毀目標。

在大規模無人機戰爭中人工智能會協調數千架無人機進行系統性攻擊。與人類必須批准每次射擊的一方相比,讓人工智能自主射擊的一方將在速度上獲得很大優勢。

Jason Ma說,「在單個射擊層面上講,人類必須放棄控制,因為他們無法真正如此迅速地做出所有決定。」

Ridder指出,無人機獨自射擊另一架無人機,這在道德上是可以接受的,但這可能會在戰場上釋放出大量的自主射擊,而且戰場上可能還有人類,這就會造成難以計數的附帶傷亡。

沒有規則

大多數專家都認為,無論人工智能保障措施是否可行,中國共產黨都不太可能遵守。

Jason Ma說,「我不認為中國(中共)會有任何需要謹慎的界限,只要有可能,他們就會去做。」

Fanell說,「我不認為中國(中共)會限制自己使用它,他們會試圖利用它,並能比我們更快地學會利用它。」

Jason Ma說,「受人類控制」原則可以簡單地重新解釋為適用於「更大的整體的戰鬥層面」,而不是「個人射擊層面」。

Fanell說,然而,一旦人們接受了人工智能在某些情況下可以自行射擊的事實,受人類控制原則就變得可塑了。

他說,「如果你願意在戰術意義上接受這一點,誰又能保證你不會將其上升到戰爭的最高層面呢?」

他說,「這是這種技術的自然演變,我不知道我們能做甚麼來阻止它。在戰爭中,你不可能有道德準則規定:讓我們遵守《昆斯貝里侯爵夫人拳擊規則》(the Marquess of Queensberry Rules of Boxing),這是不可能的。」

多位專家一致認為,即使人類能夠控制宏觀決策,比如,是否執行特定任務,人工智能也能輕易主導決策過程。

危險不是來自表現不佳的人工智能,而是來自工作得如此出色,以至於讓人類操作員產生信任感的人工智能。

Ridder對超級人工智能將遠遠超過人類的預言持懷疑態度。不過他也承認,人工智能在某些方面顯然超過了人類,尤其是速度。它可以對堆積如山的數據進行運算,並幾乎立即得出結論。

Qiu認為,要想弄清人工智能究竟是如何得出結論的,幾乎是不可能的。

Ridder說,他和其他人正在研究如何將人工智能限制在類似人類的工作流程中,從而使其推理的各個步驟更加透明。

但Jason Ma承認,考慮到所涉及的數據量驚人,如果人工智能解釋每條訊息是如何影響其推理的,人類操作員一定會不知所措。

他說,「如果人類操作員清楚地知道這是在人工智能處理了數個TB的數據後做出的決定,那麼在大多數情況下,他將沒有勇氣推翻這個決定,所以我想,是的,這只是走形式。『受人類控制』的說法只是聊以自慰,實際上人類會很快放棄控制權。」

公眾壓力

Ridder說,即使人類只是名義上控制著一切,這仍然很重要,「只要我們讓人類知情,我們就能讓人類負起責任。」

事實上,所有專家都認為,公眾壓力很可能會限制人工智能武器的開發和使用,至少在美國是這樣。

Jason Ma舉了一個例子,在員工的反對下,Google終止了一份國防合同,但他無法想像在中國會出現類似情況。

Qiu對此表示贊同。他說,「中國國內的任何東西都是中共可以利用的資源,你不能說,『哦,這是一家私營公司』,因為中國本來就沒有私營公司。」

但Ridder說,即使是中共也無法完全擺脫公眾的情緒,「只有民眾願意合作,政府才能生存。」

然而,並沒有跡象表明,中國民眾會認為人工智能的軍事用途是一個迫切的問題。

Jason Ma說,恰好相反,中國的公司和大學似乎正急於獲得軍事合同。

Ridder呼籲「建立一個可以執行的國際監管框架」。

目前還不清楚如何對中國執行這樣的法規,因為中國長期以來一直拒絕美國對其軍事發展施加任何限制。長期以來,美國一直夢想和中國坐下來討論核裁軍問題。最近,中國拒絕了美國提出的讓中國保證不使用人工智能做出核打擊決定的要求。

多位專家表示,如果美國對自己的人工智能發展進行監管,可能會造成戰略漏洞。

Qiu說,「中共就會很好地研究這些監管規定,並利用其作為攻擊的工具。」

Thayer認為,就算達成了某種協議,中共在信守承諾方面的記錄也不佳,「任何協議都是畫餅充飢。」

路在何方?

Ridder希望各國能以破壞性較小的方式使用人工智能。他說,「有很多方法可以利用人工智能來實現自己的目標,而不需要向對方派遣成群的殺手級無人機,除非迫不得已,沒有人希望發生這些衝突。」

不過,其他專家認為,只要中共能看到一條通往勝利的清晰道路,就不介意挑起這樣的衝突。

Fanell說,「中國人不會受制於我們制定的規則,他們會不惜一切代價取得勝利。」

Thayer認為,不能依賴人工智能軍事顧問的耳語,雖然這種顧問通過處理大量數據和制定令人信服的作戰計劃來灌輸信心,但可能會特別危險,因為它可能會在以前沒有勝利的地方創造出勝利的願景。

Thayer說,「你可以看到這對決策者有多大的吸引力,尤其是對像中共這樣具有超強侵略性的決策者,這可能會使其侵略性變得更強。」

Fanell說,「要想阻止它,只有一個辦法,那就是打敗它。」

五角大樓網絡評估辦公室前顧問Chuck de Caro最近呼籲美國開發可使電腦晶片失效的電磁武器。他在Blaze上的一篇專欄文章中提出,有可能開發出能讓某種晶片失效的能量武器。

他說,「很顯然,沒有正常運作的晶片,人工智能就無法工作。」

另一種選擇可能是開發一種可以起到威懾作用的人工智能超級武器。

Fanell問道,「美國是否正在進行一項人工智能版的『曼哈頓計劃』?能夠對中華人民共和國和中國共產黨產生長崎和廣島那樣的影響,能讓他們意識到,『好吧,也許我們不想走到那一步,那不是相互確保毀滅嗎?』;我不知道,但(如果我是美國領導人)我會這樣做。」

這可能會讓世界陷入類似冷戰的對峙狀態。這並不是一種理想狀態,但很可能比放棄軍事優勢給中共更可取。

Jason Ma說,「每個國家都知道這樣做很危險,但沒有人能停下來,因為他們害怕自己會被(對手)拋在後面。」

Ridder說,可能需要一場巨大的衝擊才能阻止人工智能軍備競賽。他說,「我們可能需要一場世界大戰,造成巨大的人類悲劇,才能最終禁止使用自主人工智能殺人機器。」#

原文:CCP Develops AI Weapons, Ignoring Global Risks刊登於英文《大紀元時報》。

--------------------

向每位救援者致敬

願香港人彼此扶持走過黑暗

--------------------

🔔下載大紀元App 接收即時新聞通知:

🍎iOS:https://bit.ly/epochhkios

🤖Android:https://bit.ly/epochhkand

📰周末版實體報銷售點👇🏻

http://epochtimeshk.org/stores