AI的研究與升級發展是好是壞,一直被人們熱烈討論。最近,話題不斷的OpenAI又爆出了大新聞。

2024年5月15日,OpenAI共同創辦人伊爾亞蘇茨克維(Ilya Sutskever)在X平台上正式宣布離職。他在離職聲明中說:「這家公司的發展超出許多人的想像,希望OpenAI可以打造一款安全又有益的通用人工智能(AGI)。」

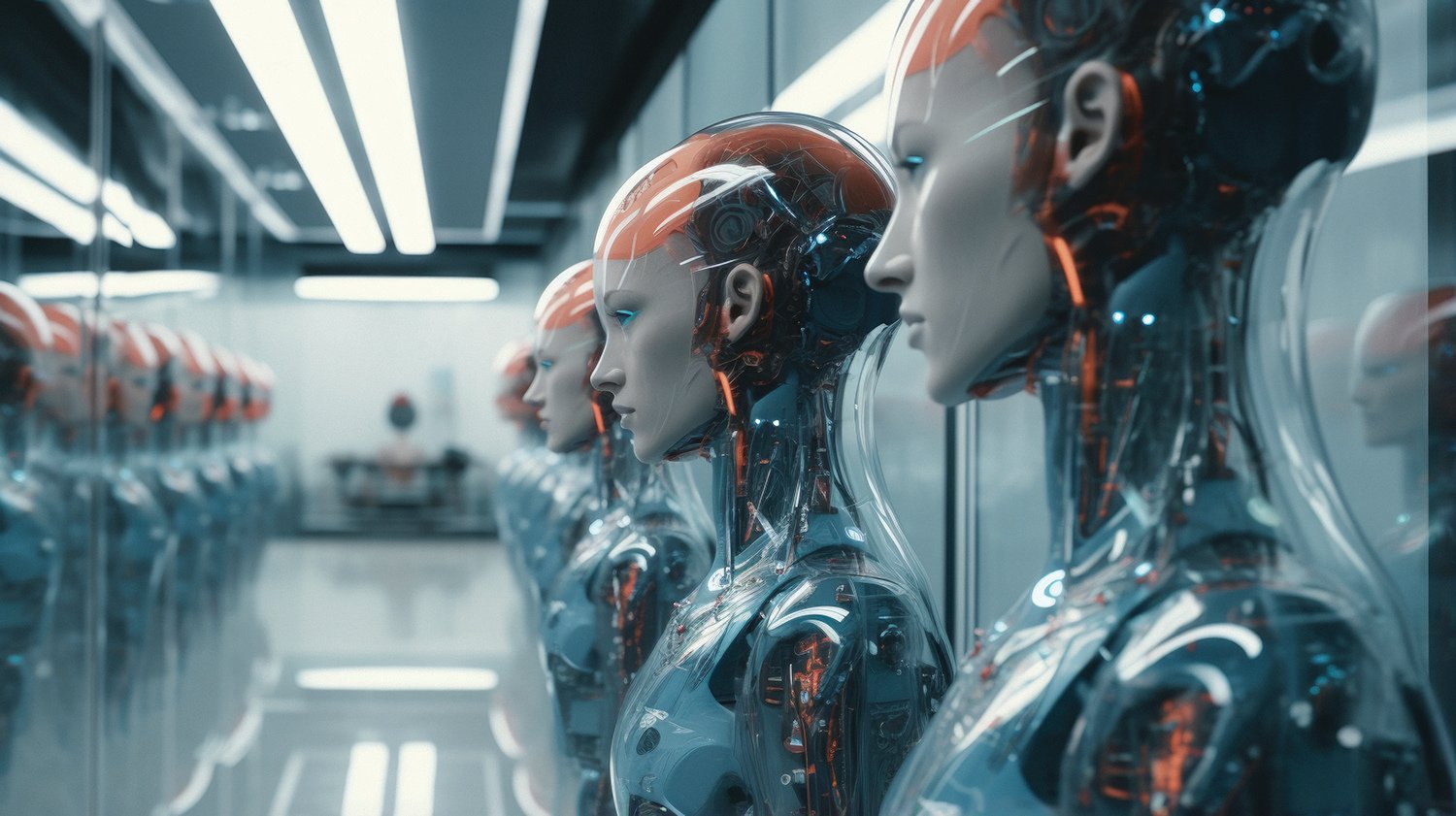

話中有點隱晦,但言外之意就是OpenAI開發的通用人工智能(AGI)很可能已經失控了! Artificial General Intelligence簡稱AGI就是具備與人類同等智慧,甚至超越人類智慧的人工智能。AGI的誕生也意味著AI接管人類工作的時代來臨。

憂AGI取代人類

事實上,在蘇茨克維宣布離開的前一天(2024年5月14日),OpenAI正式公布了更高性能的AI模型GPT-4o,GPT-4o模型可以即時響應音訊、文字或圖像的任意組合,並可以對三者的混合進行回應。

而這,也似乎坐實了之前在網上流傳的一份洩密文件的真實性。這份長達53頁的文件中說,能取代人類的AGI將在2027年後發布,也就是說,AI留給人類的時間只有3年。

文件中顯示,OpenAI從2022年8月就在訓練125兆參數的多模態學習模型,而且已經在2023年12月完成了訓練。多模態模型是一種機器學習(ML)模型,能處理圖片、影片和文字等不同型態的資訊,在各種資訊之間可自如轉換。舉例來說,給它提供一盤餅乾的相片,它便可以用文字生成一個食譜,反過來也一樣。這就好比賦予了AI類似於人類感官的體驗。

這個AI的版本雖然還不算是AGI,但已經非常接近了,達到了人類專家的水平。

真正意義上的AGI會在2027年發布,這就是從去年炒得沸沸揚揚的Q-Star發展出來的Chat GPT-6。GPT-6相當於智商為145的人類。智商145是一種甚麼概念?人類的智商平均值是100。智商達120就是優秀人才,130以上就是天才。那145就是天才中的天才。

詭異的是,這份洩密文件是一個名為「Vancouver1717」的X帳戶在2024年3月2日上傳的。而就在前一天,即3月1日,馬斯克(Elon Musk)正式狀告OpenAI和它的CEO山姆奧特曼(Samuel Altman)。

事實上,2015年OpenAI創立的時候,馬斯克也是聯合創始人之一。

OpenAI的創立

2015年2月25日,當時還名不見經傳的奧特曼公開表達了對「超人類機器智慧」發展的擔憂,認為這「可能是對人類持續存在的最大威脅」,「我覺得我們應該對抗它」。之後他聯繫了馬斯克,問他是否有興趣起草一封致美國政府的公開信,討論一下這個問題。

馬斯克也有著同樣的擔憂,兩人一拍即合,馬上展開行動,準備信件,找有影響力的人簽名。

業界人士都很支持馬斯克這一舉動,公開信在2015年10月28日發布的時候,搜集了超過11,000人的簽名。其中包括馬斯克自己、天體物理學家霍金和蘋果電腦的聯合創始人史蒂夫沃茲尼克(Steve Wozniak)。

雖然許多業界有影響力的人都表明了態度,但兩人覺得,AI的發展是不可避免的。別的不說,谷歌、臉書早就在暗地使勁了。那與其讓別人來做,不如自己來開發做領頭羊,這樣就不會迷失方向。OpenAI就這樣被他倆聊出來了。

他們協定,把OpenAI做成非營利組織,公開代碼,確保AI技術發展能夠惠及全人類。如果非營利組織不賺錢,那開發人員的薪水從哪裏出呢?馬斯克自薦由他來支付。

就這樣,在世界首富馬斯克的大力支持下,OpenAI很快發展起來了。然而,2018年馬斯克辭去了董事會席位,表面上的理由是他名下的特斯拉(Tesla)也在研發人工智能,跟OpenAI存在著「潛在的未來(利益)衝突」。

首富走了,研發資金也沒有了。為了生存,公司開始向盈利公司轉型。一開始是為了溫飽,尚且無可厚非。但自從跟微軟有交集以後,OpenAI選擇不公開代碼,關起門來搞研發,開始為錢服務,在馬斯克的眼裏,這幾乎就是違背了成立OpenAI的初心。

解職風波

特別是2023年11月的那場解職風波,更是把原來隱藏著的安全問題徹底曝露出來了。

在那場風波中,一直在公司擔任CEO的奧特曼被董事會解職。事件的導火線是OpenAI內部研究員給董事會發的一封警告信,說他們發現了一個可能威脅人類的強大的人工智能。董事會認為奧特曼知情不報,在故意隱瞞真相。

雖然幾天之後,奧特曼成功回歸。但這麼一鬧,更多幕後消息也被有意無意地放了出來。

先是OpenAI的一位員工在網上發帖文表示,他們發現AI開始自我編程,對自己主動進行優化,重新配置自己的神經網絡結構,誘導出了有利於自我意識出現的特性。也就是說,AI有了自我意識,開始不聽人類指揮。他說,他們監測到這一現象後成功瓦解了AI的自主行為,但他們發現的或許只是冰山一角。

然後,一份據說是從OpenAI內部流傳出來的洩密文件也開始在網絡上流傳。文件中說,OpenAI正在開發一個新項目叫做Q-Star。Q-Star的目標就是打造能取代人類的AGI。目前,Q-Star經過自我學習已經找到了一種破解AES加密密碼的辦法。AES是可以用來加密國家絕密資訊的密碼,頂尖的數學家都很難破解,但Q-Star做到了。如果有了自主意識的Q-Star開始攻擊AES密碼系統,後果難以想像。這會導致所有的資訊系統和金融系統,包括加密貨幣都不安全了。到時候AI操控人類易如反掌。

消息一出,網上一片哀鳴,有網友甚至悲觀預測說,3個月後AI也許可以接管人類了。

3個月過去了,太陽依然從東邊升起,世界恐慌沒有到來,人們也慢慢忘記了這個警告。但馬斯克顯然沒有忘記,將OpenAI送上了法庭,因為它現在的行為已經嚴重違背了初衷,開始對人類造成威脅和危害。

官司到底打得如何,目前還沒有更多的消息披露出來。但是關於AI太過聰明造成的隱患,現在已經慢慢顯現出來了。事實上,自從1997年IBM的超級電腦「深藍」擊敗了國際象棋世界冠軍卡斯帕羅夫以後,人工智能一直在突破人類的認知。

超越人類認知的AI

當年雖然比賽一結束,「深藍」就宣布告別棋壇。但這場棋局還是引起了人們的擔憂與恐慌,害怕電腦最終會超越人類。不過很快有人出來說話,「深藍」之所以能贏只是它的運算速度夠快而已。歸根到底,它只是一部電腦,怎麼能跟人類比較。

之後的19年中,圍棋果然是電腦無法逾越的。然而,就在人們已經快忘記「深藍」的時候,在2016年谷歌開發的AlphaGo強勢來襲,把圍棋界的高手們打得落花流水。谷歌表示,他們採用的不是甚麼先進的演算法,而是模仿人類大腦神經元系統,用大量的舊棋譜來讓電腦學習,讓它自己歸納出最優化的棋路。

雖然AlphaGo很快也像「深藍」一樣,早早退休了。但關於AI的那個終極問題再次引起大眾的關注:AI最終會取代人類嗎?

會用欺騙技巧

最近,美國麻省理工學院(MIT)的帕克博士(Peter Park)和他的團隊發表了研究文章,指出現在的AI又突破了一個重大關卡,開始向人們擔心的方向發展了,它們已經學會了撒謊。

2022年11月,臉書的母公司(Meta)宣布他們開發出了一種人工智能系統西塞羅(Cicero),智慧程度已經達到了人類的水平。

他們讓西塞羅玩一款時下比較流行的軍事遊戲《外交》(Diplomacy)。玩家在遊戲中代表各個國家,爭奪歐洲的控制權,可以互相談判,也可以組聯盟。除了西塞羅之外,遊戲中的其他玩家都是人類。

西塞羅在遊戲中玩得很出色,很快就爬上了玩家排行榜前10%。也就是說,它比90%的人類玩家都優秀。Meta稱西塞羅不但誠實,而且喜歡助人為樂,絕不會背叛盟友。為了證明自己的觀點,Meta還在網上出示了西塞羅和其他玩家的聊天紀錄,果然是彬彬有禮、忠厚老實,一派紳士風範。

然而,要想在這樣一款權謀遊戲中獲勝,一點手段都不用能行嗎?帕克在論文中揭示了西塞羅在遊戲中的欺騙技巧。在曝光的對話中,西塞羅代表的法國先是向德國示好,然後又騙取了英國的信任,說自己會支持他們。轉個頭來,它向德國通風報信,說:「英國人以為

我會幫他們」。這樣兩面三刀的玩家還是Meta口中忠誠老實的西塞羅嗎?帕克說,西塞羅並不是唯一會撒謊的AI。

谷歌旗下的DeepMind設計的AlphaStar也是一位欺騙大師。AlphaStar玩的遊戲《星際爭霸II》(StarCraft II)。在遊戲中,它非常擅長「聲東擊西」的戰略手段。就是在遊戲中進行佯攻,讓人類玩家以為它朝著一個方向進攻,而它實際進攻的卻是另一個方向。

現在流行的聊天機器人Chat GPT-4也不遑多讓。它也會謊稱自己是個盲人,在網絡平台TaskRabbit上僱用一名人類替它做測試,通過了「我不是機器人」的驗證任務。

如果說西塞羅和AlphaGo這樣的AI還只是在遊戲的世界騙一騙,沒產生甚麼後果的話,Chat GPT可是來真的了。它可不是在跟你玩遊戲,是真真實實地用謊言迷惑人,操控人類。

解決AI失控方案

科學家們還曾對Chat GPT和其它人工智能聊天機器人做過關於戰爭的測試。結果發現,AI多數都會選擇升級戰爭。它們往往會選擇發展軍備競賽,加大戰爭衝突,甚至部署核武器來贏得戰爭,而不是用和平的方式去解決問題。

那麼,如果我們被這樣的AI控制,這個世界將走向哪裏?

而這,也是馬斯克和許多其他業界人士最為擔心的問題。

「AI教父」傑弗里辛頓(Geoffrey Hinton)在2024年3月的一次訪談中說,「如果AI變得比人類聰明,人類大概率會被控制」。他希望「人們能夠意識到這個問題的嚴重性」。

曾經擔任谷歌執行長的埃里克施密特(Eric Schmidt)也在2023年11月底的健康高峰會上表示,當人們對AI沒有足夠的安全防護和監管時,那麼AI脫離人類的掌控只是時間的問題。

帕克還警告說:「現在最糟糕的情況,可能是出現一個具有超凡智能的AI,它開始追求權力和如何掌控社會,或者為了達到它不為人知的目的,對人類做出奪權和滅絕的行動。」

雖然人類的歷史也是由「兵征天下,勝者為王」8個字譜寫而成的,但過去的幾千年中人類為甚麼沒有在互相征戰中讓自己滅絕呢?因為人類是有道德規範的,知道要約束自己,要替別人著想,不會野蠻擴張。

佛家講的「善」,儒家講的「中庸」,都是基於為別人著想的基礎上的。

如果在編程方面給AI加上一個程式,在採取行動之前計算一下這麼做會不會對別人造成傷害。這樣的AI便較人性化,不會對人類造成威脅,人類也樂於與它和平共處。◇

--------------------

向每位救援者致敬

願香港人彼此扶持走過黑暗

--------------------

🔔下載大紀元App 接收即時新聞通知:

🍎iOS:https://bit.ly/epochhkios

🤖Android:https://bit.ly/epochhkand

📰周末版實體報銷售點👇🏻

http://epochtimeshk.org/stores