如今越來越多的人使用AI生成語音來說故事、做客服等,但這一技術也在被高智商犯罪份子所利用。最令人擔憂的是,即使經過AI語音分辨訓練的人們,仍很難檢測和分辨用AI做出來的語音。

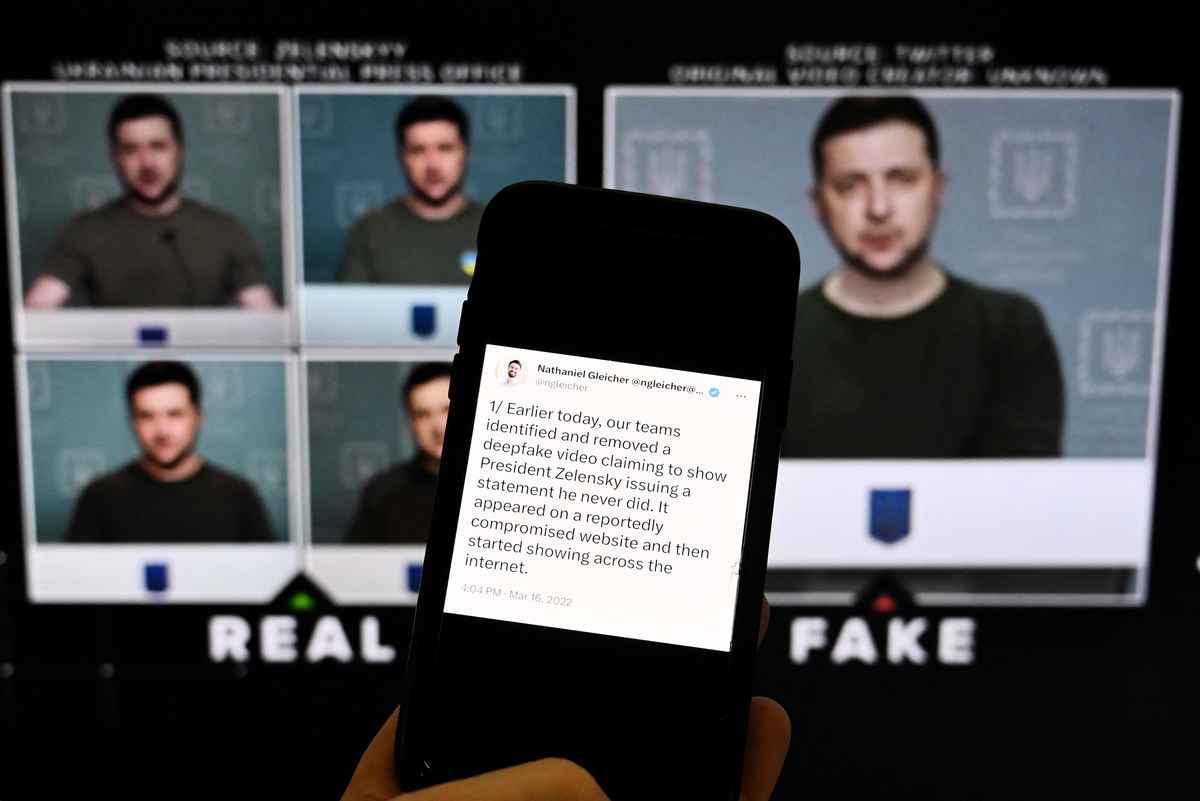

這種模仿真人聲音和外表的影音片段被稱之為「深度偽造」(Deepfakes),儘管這種技術早已不新鮮,但隨著AI的快速發展,這種技術被濫用情況也隨之增加,這使得Deepfakes產生的問題越發嚴重。

英國倫敦大學學院(University College London,UCL)的團隊對此做了深入研究。他們向平均年齡為29歲的529名受試者(男女比例各半),播放真實音頻和深度偽造音頻(中英文),並要求他分辨哪些是真實的,哪些是偽造的。

實驗中,他們將受試者隨機進行兩種配置的測試。第一種配置,是向受試者提供一個音頻剪輯,並要求他們判斷剪輯的真偽。第二種配置,是向受試者提供相同語音的音頻剪輯,其中音頻包括真實的和合成的,並要求他們辨別其中的合成音頻。

結果發現,受試者在判斷政客的深度造假內容時,大多依靠政治素養和背景知識,來識別內容的真偽,但若去除這些背景知識會使檢測任務變得更加困難。

另外,研究還發現在2-11秒內的Deepfakes短語音更不容易被識別,但語音每增加一秒內容,會提高0.80%的識別率。不過,更頻繁或花更長時間收聽剪輯音頻,並無助於檢測真假。

實驗結果顯示,不論這些受試者聽到是中文還是英文,始終只有70%左右的概率能夠分辨哪些是偽造的,與67.78%的機率分辨出哪些是真實的。

儘管這些受試者經過識別Deepfakes語音的訓練,但情況只會有些許的改善。此研究成果日前發表在公共科學圖書館(Plos One)網站上。

研究人員警告,由於AI技術日新月異,現在只需使用少量音頻樣本,就可能產生與真人相似的語音。除了冒充之外,犯罪份子還可能使用Deepfake進行魚叉式網絡釣魚、傳播虛假新聞和繞過生物辨識認證系統。

論文中舉了幾個關於Deepfakes詐騙案例。其中一個是,2020年香港一位銀行經理接到了一通電話,電話中傳來與公司董事相似的聲音,該聲音要求銀行經理批准3,500萬美元的轉賬,當他轉賬40萬美元後,才意識到不對勁。

今年6月,有一名女子在網上發布關於快速換臉的警告影片,影片中她可以利用AI變換多個中國人面孔,甚至東南亞面孔都能夠更換。她警告說,即使是影片聊天也需謹慎小心。

另外,今年4月中國的一名罪犯利用AI換臉和仿聲音喬裝成受害者的好友模樣進行借錢,騙走受害人約60萬美元。

研究人員警告說,預計在2026年將有多達90%的網上內容,是AI與人工混合生成的,這使得辨別這些內容更具有挑戰性。另外,虛假資訊會在多個層面上摧毀人與人之間的信任,因此了解Deepfakes和它潛在的犯罪威脅,變得至關重要。

美國白宮擔憂AI衍生巨大風險,因此拜登在今年7月中請來了美國的Amazon、Anthropic、Google、Inflection、Meta、Microsoft和OpenAI,共7大科技巨頭,要求他們許下安全、可靠與信任的承諾。

為此,這7家科技公司的領袖們允諾,在AI產業徹底改變社會之際,從網絡攻擊到欺詐等方面,會做好全面防堵行動。

目前有幾種方法可以識別Deepfakes影音或圖像,包括影像中的人物眨眼和眼球運動出現不自然現象、面部表情不自然、奇怪的的五官定位、缺乏人類應有的情感、身體或姿勢看起來很怪異或不自然、膚色和光線不正常、頭髮和牙齒看起來不真實、圖像邊緣模糊或視覺效果錯位、噪音或音頻不一致、放慢速度時圖像看起來不自然,或者對圖片進行反向搜索。

該研究的第一作者、倫敦大學學院電腦科學金伯利·麥(Kimberly Mai)對美國科學促進學會(AAAS)表示:「我們的研究結果證實,人類無法可靠地檢測Deepfakes語音,無論他們是否接受過識別培訓。」

他補充說,「值得注意的是,我們在這項研究中使用的樣本是用相對較舊的算法創建的。也就是說,人類在未來可能無法檢測到使用現在和未來最先進的技術創建的Deepfake語音。」

另外一位研究者劉易斯·格里芬(Lewis Griffin)教授則表示,「隨著生成AI工具和技術變得越加繁雜,我們不僅會看到好處也會看到更多的風險。對此,政府和組織應積極做出監管的措施,來應對AI可能產生的風險。」@

------------------

📰支持大紀元,購買日報:

https://www.epochtimeshk.org/stores

📊InfoG:

https://bit.ly/EpochTimesHK_InfoG

✒️名家專欄:

https://bit.ly/EpochTimesHK_Column

--------------------

向每位救援者致敬

願香港人彼此扶持走過黑暗

--------------------

🔔下載大紀元App 接收即時新聞通知:

🍎iOS:https://bit.ly/epochhkios

🤖Android:https://bit.ly/epochhkand

📰周末版實體報銷售點👇🏻

http://epochtimeshk.org/stores